La vitamina D migliora le difese verso il Covid 19

I ricercatori del Trinity College di Dublino chiedono al governo irlandese di modificare le raccomandazioni per gli integratori di vitamina D. Una nuova ricerca della dott.ssa Eamon Laird e della professoressa Rose Anne Kenny, School of Medicine, e dell’Irish Longitudinal Study on Aging (TILDA), in collaborazione con il professor Jon Rhodes _Università di Liverpool_, sottolinea l’associazione tra livelli di vitamina D e la mortalità da COVID-19. Gli autori, hanno analizzato tutti gli studi sulla popolazione adulta europea, completati dal 1999, che hanno misurato la vitamina D e confrontato la vitamina D e i tassi di mortalità da COVID-19. La vitamina D viene prodotta nella pelle dall’esposizione alla luce solare UVB e viene trasportata nel fegato e poi nel rene dove viene trasformata in un ormone attivo che aumenta il trasporto del calcio dal cibo nell’intestino e, garantisce che il calcio sia adeguato a mantenere lo scheletro forte e libero di osteoporosi.La vitamina D può anche supportare il sistema immunitario attraverso una serie di vie immunitarie coinvolte nella lotta contro la SARS-CoV-2. Molti studi recenti confermano il ruolo chiave della vitamina D nelle infezioni virali. Questo studio mostra che, contrariamente a quanto si pensa, intuitivamente, i paesi a bassa latitudine e i paesi tipicamente soleggiati, come la Spagna e il Nord Italia, avevano basse concentrazioni di vitamina D e alti tassi di carenza di vitamina D. Questi paesi hanno anche registrato i più alti tassi di infezione e mortalità in Europa. I paesi della latitudine settentrionale di Norvegia, Finlandia e Svezia hanno livelli più alti di vitamina D nonostante una minore esposizione alla luce solare UVB, poiché l’integrazione e la fortificazione degli alimenti sono più comuni. Questi paesi nordici hanno tassi di infezione e mortalità per COVID-19 più bassi. La correlazione tra bassi livelli di vitamina D e morte per COVID-19 è statisticamente significativa. Mentre l’ottimizzazione dei livelli di vitamina D andrà sicuramente a beneficio della salute delle ossa e dei muscoli, i dati suggeriscono che è probabile che riduca anche gravi complicanze della COVID-19. Ciò può essere dovuto al fatto che la vitamina D è importante nella regolazione e nella soppressione della risposta infiammatoria delle citochine, che causa le gravi conseguenze della COVID-19 e la “sindrome da distress respiratorio acuto” associata alla ventilazione e alla morte. “In Inghilterra, Scozia e Galles, -ha dichiarato Rose Anne Kenny– gli enti di salute pubblica hanno rivisto le raccomandazioni dopo l’epidemia di COVID-19. I consigli ora affermano che tutti gli adulti dovrebbero assumere almeno 400 UI di vitamina D al giorno. Attualmente non ci sono risultati da studi controllati randomizzati per dimostrare in modo conclusivo che la vitamina D influisce positivamente sugli esiti di COVID-19, vi sono forti prove circostanziali di associazioni tra e la gravità delle risposte di COVID-19, compresa la morte. ” Lo studio conferma ulteriormente questa associazione. Il governo irlandese dovrebbe perciò aggiornare le linee guida con urgenza e incoraggiare tutti gli adulti a prendere integratori durante la crisi COVID-19. La carenza è frequente in Irlanda. La carenza è prevalente con l’età, l’obesità, negli uomini, nelle minoranze etniche, nelle persone con diabete, ipertensione e nelle case di cura”. “Nelle prove osservative-ha aggiunto il dr. Eamon Laird- si riscontra un legame tra vitamina D e mortalità. L’ottimizzazione dell’assunzione di vitamina D secondo le linee guida di salute pubblica avrà sicuramente benefici per la salute generale e sosterrà la funzione immunitaria. Ricerche come questa sono ancora esplorative e necessitano ulteriori studi per avere prove concrete sul livello di vitamina D necessario per una funzione immunitaria ottimale. Tuttavia, studi come questo ci ricordano anche quanto sia basso il nostro stato di vitamina D nella popolazione (anche nei paesi soleggiati) e aggiunge ulteriore peso a una sorta di politica obbligatoria di fortificazione della vitamina D. Se i paesi nordici sono autorizzati a farlo, non c’è motivo per cui l’Irlanda, il Regno Unito o il resto dell’Europa non possano farlo. “

Una “freccia avvelenata” per uccidere i batteri resistenti agli antibiotici

Il veleno è letale da solo – e le frecce – che insieme possono abbattere gli avversari più forti. Scoperto un antibiotico che perfora simultaneamente le pareti batteriche e distrugge il folato all’interno delle loro cellule – uccidendo come una freccia avvelenata – dimostrando al contempo di essere immune alla resistenza agli antibiotici.

Il veleno è letale da solo – come lo sono le frecce – ma la loro combinazione è di maggiore efficacia. Un’arma che attacca simultaneamente dall’interno e dall’esterno può abbattere anche gli avversari più forti, da E. coli a MRSA (Staphylococcus aureus resistente alla meticillina). Un team di ricercatori di Princeton riferisce di aver trovato un composto, SCH-79797, che può contemporaneamente perforare le pareti batteriche e distruggere il folato all’interno delle loro cellule – pur essendo immune alla resistenza agli antibiotici. Le infezioni batteriche sono di due tipi: Gram-positive e Gram-negative – chiamate così per lo scienziato che ha scoperto come distinguerle. La differenza fondamentale è che i batteri Gram-negativi sono corazzati con uno strato esterno che elimina la maggior parte degli antibiotici. Nessuna nuova classe di farmaci che uccidono Gram-negativi è arrivata sul mercato da quasi 30 anni. “Questo è il primo antibiotico in grado di colpire Gram-positivi e Gram-negativi senza resistenza, -ha dichiarato Zemer Gitai, professore di biologia all’ Edwin Grant Conklin– Princeton e autore del documento. “Dal punto di vista del ” perché è utile “, questo è il punto cruciale. Questi scienziati sono più entusiasti di qualcosa che rivela su come funziona questo antibiotico – attaccando attraverso due diversi meccanismi all’interno di una molecola – quindi siamo speranzosi che la speranza sia generalizzabile, portando a migliori antibiotici – e nuovi tipi di antibiotici – in futuro “. La più grande debolezza degli antibiotici è che i batteri si evolvono rapidamente per resistere a loro. Ebbene il team di Princeton ha scoperto che anche con uno sforzo straordinario, non erano in grado di generare alcuna resistenza a questo composto. “Questo è davvero promettente, -ha detto Gitai -, motivo per cui chiamiamo i derivati del composto ‘Irresistin'”. È il Santo Graal della ricerca sugli antibiotici: un antibiotico efficace contro le malattie e immune alla resistenza pur essendo sicuro nell’uomo (a differenza dello sfregamento di alcol o candeggina, irresistibilmente fatali sia per le cellule umane che per le cellule batteriche). “Per un ricercatore di antibiotici, -ha detto James Martin, dottorato di ricerca del 2019- è come scoprire la formula per convertire il piombo in oro o cavalcare un unicorno – qualcosa che tutti vogliono ma nessuno crede davvero che esista”. Martin ha trascorso gran parte della sua carriera di laurea lavorando a questo composto. “La mia prima sfida, – ha poi detto-, è stata convincere il laboratorio che era vero”. L’irresistibilità è un’arma a doppio taglio. La tipica ricerca sugli antibiotici prevede la ricerca di una molecola in grado di uccidere i batteri, l’allevamento di più generazioni fino a quando i batteri non sviluppano resistenza ad essa, osservando come opera esattamente quella resistenza e utilizzandola per decodificare il funzionamento della molecola. SCH-79797 è irresistibile, per cui non c’era nulla da decodificare. “Questa è stata, -rimarca Gitai-, una vera impresa tecnica”. “Nessuna resistenza è un vantaggio dal lato dell’utilizzo, ma una sfida dal lato scientifico.” Il team di ricerca ha affrontato due enormi sfide tecniche: cercare di dimostrare il negativo – cioè nulla può resistere a SCH-79797 – e quindi capire come funziona il composto. Per dimostrare la sua resistenza alla resistenza, Martin ha provato infiniti test e metodi diversi, nessuno dei quali ha rivelato una particella di resistenza al composto SCH. Alla fine, ha provato la forza bruta: per 25 giorni, l’ha “superato in serie”, il che significa che ha esposto i batteri al farmaco ancora e ancora e ancora. Poiché i batteri impiegano circa 20 minuti per generazione, i germi hanno avuto milioni di possibilità di sviluppare resistenza – ma non lo hanno fatto. Per verificare i loro metodi, il team ha anche sottoposto in serie altri antibiotici (novobiocina, trimetoprim, risina e gentamicina) e hanno rapidamente sviluppato resistenza nei loro confronti. Dimostrare un negativo è tecnicamente impossibile, quindi i ricercatori usano frasi come “frequenze di resistenza irrimediabilmente basse” e “nessuna resistenza rilevabile”, ma il risultato è che SCH-79797 è irresistibile – da qui il nome che hanno dato ai suoi composti derivati, Irresistin. Hanno anche provato a usarlo contro le specie batteriche note per la loro resistenza agli antibiotici, tra cui la Neisseria gonorrhoeae, che è nella top 5 delle minacce urgenti pubblicata dal Center for Disease Control and Prevention. “La gonorrea, – ha detto Gitai-, pone un enorme problema rispetto alla resistenza multidroga. Abbiamo esaurito i farmaci per la gonorrea. Con le infezioni più comuni, i farmaci generici della vecchia scuola funzionano ancora. Quando due anni fa mi sono fatto male alla gola, mi è stata somministrata la penicillina-G – la penicillina scoperta nel 1928! Ma per N. gonorrhoeae, i ceppi standard che circolano nei campus universitari sono super resistenti ai farmaci. Quella che era l’ultima linea di difesa, il farmaco di emergenza in caso di emergenza per Neisseria, è ora in prima linea standard di cura. Ecco perché questo è particolarmente importante ed eccitante che potremmo curare “. È stato persino ottenuto un campione del ceppo più resistente di N. gonorrhoeae dalle volte dell’Organizzazione mondiale della sanità – un ceppo resistente a tutti gli antibiotici conosciuti – e “Joe , – ha detto Gitai -, ha mostrato che il nostro ragazzo ha ancora ucciso questo ceppo, con un palese riferimento a Joseph Sheehan, co-primo autore del documento e direttore del laboratorio del Gitai Lab. Per cui siamo piuttosto entusiasti di questo.”

La freccia a punta di veleno Sono stati impiegati anni a cercare di determinare in che modo la molecola uccide i batteri, utilizzando una vasta gamma di approcci, dalle tecniche classiche in circolazione dalla scoperta della penicillina alla tecnologia all’avanguardia. Martin, alla fine, ha rivelato che SCH-79797 utilizza due meccanismi distinti all’interno di una molecola, come una freccia ricoperta di veleno.”La freccia deve essere affilata, – ha detto Benjamin Bratton, associato di biologia molecolare e docente al Lewis Sigler Institute for Integrative Genomics, secondo co-primo autore- per ottenere il veleno, ma anche il veleno deve uccidere da solo”.La freccia prende di mira la membrana esterna – penetrando anche attraverso la spessa armatura di batteri Gram-negativi – mentre il veleno distrugge i folati, elemento fondamentale di RNA e DNA. C’è stata sorpresa nello scoprire che i due meccanismi operano in sinergia, combinandosi in più di una somma delle loro parti. “Se prendi solo quelle due metà, – ha detto Bratton -, ci sono farmaci disponibili in commercio che possono attaccare una di quelle due vie – ma non uccidono in modo efficace come la nostra molecola, a cui sono uniti insieme sullo stesso corpo “. C’era un problema: l’originale SCH-79797 uccideva le cellule umane e le cellule batteriche a livelli più o meno simili, e come medicina correva il rischio di uccidere il paziente prima di uccidere l’infezione. Il derivato Irresistin-16 lo ha corretto. È quasi 1.000 volte più potente contro i batteri rispetto alle cellule umane, rendendolo un antibiotico promettente. La conferma finale è stata quella di dimostrare di poter usare Irresistin-16 per curare i topi infetti da N. gonorrhoeae. La speranza Il paradigma della freccia avvelenata potrebbe rivoluzionare lo sviluppo di antibiotici, – ha affermato KC Huang, professore di bioingegneria, microbiologia e immunologia all’Università di Stanford- non coinvolto in questa ricerca.”Il particolare, – ha detto Huang-, che non può essere sopravvalutato è che la ricerca antibiotica si è fermata per un periodo di molti decenni. È raro trovare un campo scientifico che sia così ben studiato e tuttavia così bisognoso di una scossa di nuova energia.La freccia avvelenata, -ha aggiunto Huang, ricercatore post dottorato a Princeton dal 2004 al 2008- , la sinergia tra due meccanismi di attacco dei batteri, può fornire esattamente questo”. Questo composto è già così utile da solo, ma anche le persone possono iniziare a progettare nuovi composti ispirati da questo. Questo ha reso il lavoro così eccitante. “In particolare, ciascuno dei due meccanismi – la freccia e il veleno – prende di mira i processi presenti sia nei batteri che nelle cellule dei mammiferi. Il folato è vitale per i mammiferi (motivo per cui alle donne in gravidanza viene detto di assumere acido folico) e, naturalmente, sia i batteri che le cellule dei mammiferi hanno membrane. C’è un’intera classe di obiettivi che è stato in gran parte trascurato perché si pensava: “Non posso bersagliarlo, – ha detto Gitai – perché allora ucciderei anche l’umano'”. “Questo studio afferma, – ha concluso Huang-, che possiamo tornare indietro e rivisitare quelli che pensavamo fossero i limiti del nostro sviluppo per nuovi antibiotici. Da un punto di vista sociale, è fantastico avere nuove speranze per il futuro”.

FERMILAB FORNISCE L’ULTIMO COMPONENTE PER INDAGARE AL MEGLIO SU PROCESSI BIOLOGICI E CHIMICI

Il Fermilab fornisce il componente finale dell’acceleratore di particelle superconduttori per il laser più potente del mondo Oggi, il Fermilab del Dipartimento dell’Energia ha spedito il suo componente superconduttore finale per il nuovo acceleratore di particelle per Linac Coherent Light Source II, o LCLS-II, presso lo SLAC National Accelerator Laboratory del DOE. Il criomodulo, componente principale dell’acceleratore lineare, è l’ultimo richiesto per il progetto LCLS-II, che una volta completato sarà il laser a raggi X più luminoso del mondo. “Questo è ciò a cui lavoriamo da sei anni. Dal 2014, il nostro team,- ha affermato Rich Stanek, capo del team senior di LCLS-II- Fermilab ha progettato, costruito, testato e fornito i criomoduli superconduttori ad alte prestazioni che costituiranno questa macchina di scoperta all’avanguardia . L’invio di oggi è il vincolo del nostro impegno di contributo. Siamo onorati di far parte di LCLS-II, sfruttando la nostra esperienza nella tecnologia di accelerazione dei superconduttori per alimentare il fascio di particelle per un laser a raggi X di livello mondiale. Tutti coloro che sono collegati al progetto LCLS-II dovrebbero essere molto orgogliosi dei loro risultati “. Un aggiornamento dell’LCLS di SLAC, che è stato il primo laser a elettroni liberi a raggi X duri al mondo, LCLS-II fornirà un passo da gigante in termini di capacità. Emetterà l’incredibile cifra di 1 milione di impulsi di raggi X al secondo, rispetto ai 120 impulsi al secondo di LCLS. Armati di questi raggi di luce a fuoco rapido, gli scienziati che utilizzano LCLS-II saranno in grado di esaminare processi biologici e chimici microscopici in tempo reale e con dettagli estremi.

L’acceleratore di particelle che fornisce gli elettroni ad alta energia per il laser LCLS-II sarà composto da 37 criomoduli, il più lungo dei quali è di 12 metri di lunghezza. Allineati da un capo all’altro come automobili in un treno, formano una specie di pista per il fascio di elettroni mentre aumenta di energia. Diciotto dei criomoduli provengono dal Fermilab e diciannove provengono dal Jefferson Lab del Dipartimento dell’Energia. Entrambi i laboratori hanno fornito ricambi aggiuntivi.

Il criomodulo del Fermilab è lungo 12 metri e inizierà il trasporto verso SLAC il 19 marzo 2021.

Una volta che il fascio di elettroni esce dai criomoduli, viene fatto muovere rapidamente da un lato all’altro attraverso una serie di ondulatori, emettendo raggi X a zig-zag. I nuovi ondulatori sono stati progettati e costruiti dal Lawrence Berkeley National Laboratory e dall’Argonne National Laboratory del DOE. La Cornell University sta anche contribuendo con componenti per LCLS-II. L’installazione del crio-modulo LCLS-II dovrebbe essere completata questa primavera e l’LCLS-II inizierà la messa in servizio nel 2022 non appena il crioplante LCLS-II sarà commissionato. LCLS-II è supportato dal Department of Energy Office of Science. “La progettazione e la costruzione dei criomoduli LCLS-II ,- ha affermato Norbert Holtkamp, vicedirettore di SLAC e direttore del progetto LCLS-II – è stata un esempio di vera collaborazione interistituzionale, riunendo le competenze e le capacità di tre laboratori nazionali nell’accelerazione delle particelle, nella scienza della superconduttività e nella scienza dei fotoni. Non vediamo l’ora di dare il benvenuto allo SLAC al criomodulo finale”. Ogni criomodulo contiene otto cavità acceleratrici superconduttive, strutture cave che assomigliano a giganteschi fili metallici di perle. Quando il fascio di particelle attraversa una cavità dopo l’altra, raccoglie energia. I criomoduli, di circa un metro di diametro, ospitano le cavità e ne consentono il raffreddamento a circa 2 kelvin, mantenendo le temperature necessarie che abilitano la superconduttività delle cavità. Negli ultimi due decenni, Fermilab ha sviluppato il suo programma di radiofrequenza superconduttrice, o SRF, che ha permesso al Fermilab di partecipare alla progettazione, costruzione e collaudo dei componenti dell’acceleratore all’avanguardia di LCLS-II. “Siamo orgogliosi di essere un partner chiave nella costruzione di questa nuova e rivoluzionaria fonte di luce,- ha affermato Alex Romanenko, Chief Technology Officer di Fermilab- e negli ultimi due decenni, gli investimenti del DOE nella fisica delle alte energie hanno consentito al Fermilab di far avanzare notevolmente la ricerca e lo sviluppo. Inoltre, sviluppare il suo programma SRF, portando a importanti scoperte nell’efficienza delle cavità SRF, grazie a scoperte come il doping con azoto e metodi di raffreddamento rapido per la riduzione campi magnetici intrappolati. Questi miglioramenti hanno contribuito ai criomoduli leader a livello mondiale di LCLS-II “. Il design del criomodulo LCLS-II SRF è una modifica di un tipo sviluppato presso il laboratorio DESY in Germania. L’ulteriore ricerca e sviluppo del Fermilab nell’area della preparazione di superfici superconduttrici ha ottenuto prestazioni da record dalle cavità dell’acceleratore, rendendole altamente efficienti dal punto di vista energetico durante l’accelerazione del fascio. Sono già in corso lavori sulla prossima generazione di criomoduli per un futuro aggiornamento ad alta energia a LCLS-II.

I tecnici del Fermilab preparano il criomodulo per il trasporto eseguendo i controlli finali sulla strumentazione.

“Fermilab e la leadership di Jefferson Lab in SRF li hanno resi i partner perfetti per impegnarsi nella progettazione e costruzione dell’acceleratore LCLS-II”, ha affermato Hanley Lee, direttore federale del progetto, il vicedirettore del DOE Bay Area Site Office. “Il nuovo laser a raggi X di SLAC non sarebbe la macchina avanzata senza questi criomoduli all’avanguardia. LCLS-II sarà uno strumento di scoperta senza precedenti, che farà luce sui processi nascosti in natura che potrebbero contenere le chiavi per migliorare la nostra salute, l’ambiente e la sicurezza. Non potremmo costruirlo senza la vasta esperienza dei ricercatori dell’ampia gamma di campi che si sono riuniti come parte di questo straordinario progetto “.Il direttore del Fermilab Nigel Lockyer concorda sul fatto che, per il successo dei criomoduli LCLS-II, la collaborazione è stata fondamentale. Il progetto LCLS-II -ha detto Lockyer– è una meravigliosa partnership dei punti di forza dei laboratori DOE. Sfruttando la scienza e la tecnologia degli acceleratori sviluppate al Fermilab per indagare gli elementi costitutivi di base della materia, ora la applichiamo a LCLS-II in modo da poter esplorare un nuovo territorio scientifico. LCLS-II è una testimonianza dello sforzo scientifico cooperativo “.

Ulteriori informazioni sui criomoduli e sul progetto LCLS-II . Fermilab è il principale laboratorio nazionale americano per la fisica delle particelle e la ricerca sugli acceleratori. Un US Department of Energy Office di laboratorio Scienza, Fermilab si trova vicino a Chicago, Illinois, e gestito con contratto dal Fermi Research Alliance LLC, una partnership tra l’Università di Chicago e l’Università Research Association, il sito web di Inc. Visita il Fermilab a www .fnal.gov e seguici su Twitter su @Fermilab . Fermilab è supportato dall’Office of Science del Dipartimento dell’Energia degli Stati Uniti. L’Office of Science è il più grande sostenitore della ricerca di base nelle scienze fisiche negli Stati Uniti e sta lavorando per affrontare alcune delle sfide più urgenti del nostro tempo. Per ulteriori informazioni, visitare energy.gov/science .

Manovra di evitamento della ISS per scongiurare impatto con detriti spaziali

Gli astronauti si sono rifugiati pronti ad una possibile ripartenza mentre la ISS veniva potenziata, con una manovra di evitamento che la disimpegnasse dal possibile impatto coi detriti orbitali La Stazione Spaziale Internazionale ha subito un riavvio non programmato in orbita , per evitare una collisione con un pezzo sconosciuto di spazzatura spaziale. All’equipaggio di tre uomini è stato ordinato di ripararsi, ma erano al sicuro. La Stazione Spaziale Internazionale (ISS) il 18 agosto 2020, disponeva di 3 astronavi attraccate tra cui le navi di rifornimento Progress 75 e 76 della Russia e la nave equipaggio Soyuz MS-16. Il riavvio della ISS di martedì è stato compiuto sparando i propulsori su una delle navi di rifornimento, mentre l’equipaggio si era riparato vicino alla Soyuz MS-16.

Mentre il suo equipaggio di tre uomini si è riparato vicino a un veicolo di fuga, la NASA e i controllori di volo russi hanno lavorato in tandem ieri per riavviare la Stazione Spaziale Internazionale su un’orbita più alta, per evitare quella che la NASA ha definito una “possibile congiunzione” con un pezzo sconosciuto di detriti spaziali. Il riavvio è stato condotto sparando propulsori su un veicolo spaziale cargo russo Progress attualmente attraccato alla ISS. I propulsori hanno sparato per 150 secondi. La manovra – avvenuta alle 17:19 di martedì 22 settembre 2020 – ha avuto successo. L’equipaggio è attualmente composto da Chris Cassidy della NASA e dai cosmonauti Anatoli Ivanishin e Ivan Vagner. Tutti e tre sono al sicuro. La NASA ha comunicato : a causa della notifica tardiva della possibile congiunzione, i tre membri dell’equipaggio della Expedition 63 sono stati indirizzati a spostarsi nel segmento russo della stazione per essere più vicini alla loro navicella Soyuz MS-16, come parte della procedura di rifugio sicuro per abbondanza di cautela .In nessun momento l’equipaggio è stato in pericolo. L’approccio più vicino stimato della ISS con il pezzo sconosciuto di detriti era stato localizzato per le 18:21 del 22 settembre. La NASA ha affermato che la manovra ha innalzato l’orbita della stazione fuori dal percorso previsto dei detriti, che è stato stimato con una velocità entro 1,39 km. Questo valore è troppo pericoloso per il comfort, soprattutto se si considera che questi oggetti nello spazio si muovono a circa 28.000 km / h, o più di 10 volte più velocemente di un proiettile in corsa. Una volta completata la manovra di evitamento, – ha detto la NASA-, l’equipaggio ha riaperto i portelli tra i segmenti USA e Russia e gli astronauti hanno ripreso le loro normali attività. Tali manovre drastiche sono un protocollo standard se c’è una probabilità di collisione maggiore di 1 su 10.000 . La ISS ha eseguito almeno 29 manovre di evitamento dal 1999.L’amministratore della NASA Jim Bridenstine successivamente ha commentato su Twitter :la Space_Station ha manovrato tre volte nel 2020 per evitare detriti. Nelle ultime due settimane, ci sono state tre potenziali congiunzioni ad alto rischio. La quantità di detriti sta peggiorando! Quest’anno, l’ Office of Space Commerce del Dipartimento del Commercio degli Stati Uniti ha chiesto altri $ 15 milioni per il suo budget per il prossimo anno, al fine di aumentare gli sforzi per monitorare e rimuovere i detriti spaziali dall’orbita. Quei fondi non sono stati ancora approvati dal Congresso degli Stati Uniti.

La micrite spiega parecchio sull’estinzione dei dinosauri

Secondo un nuovo studio, l’impatto dell’asteroide che ha ucciso la maggior parte dei dinosauri, 66 milioni di anni fa, ha anche creato le condizioni per la proliferazione dei microbi oceanici. In microscopici cristalli di roccia, sono state trovate le prove che enormi fioriture di alghe e batteri fotosintetici coprivano gli oceani del mondo, fornendo cibo a creature marine più grandi, subito dopo il cataclisma. Nel 2016, nel Golfo del Messico perforando il cratere Chicxulub, cicatrice lasciata dall’impatto dell’asteroide, sepolta sotto il fondo del mare, sono stati scoperti sedimenti ,depositati immediatamente dopo l’impatto, ricchi di micrite, un minerale di carbonato di calcio. Il carbonato di calcio precipita negli oceani del mondo: i coralli e il plancton ne formano scheletri, i microbi come i batteri lo producono e può anche formarsi direttamente dall’acqua di mare. La scoperta è stata un déjà-vu per Timothy Bralower, geologo marino della Pennsylvania State University, University Park. Nel 2001, Bralower e suoi colleghi avevano individuato la micrite nelle rocce dell’Oceano Pacifico occidentale che risalivano al momento dell’impatto. “Quando abbiamo visto ,- dice Bralower-, questo strato micrite nel cratere, siamo andati a ‘bingo”. L’avevamo già visto. ” In effetti, le rocce raccolte da 31 siti in tutto il mondo contengono uno strato di micrite che ha 66 milioni di anni, se ne rese conto Bralower, quando esaminò attentamente la sua vasta collezione di campioni di roccia montati su vetrini da microscopio. “Lo vediamo , -ha aggiunto a mo’ di ulteriore conferma- in tutti gli oceani”. Per capire come si è formato la micrite, Bralower e suoi colleghi– hanno ingrandito i minerali usando microscopi elettronici. Hanno scoperto che i suoi cristalli erano spesso composti da microcristalli ancora più piccoli a forma di romboedro a sei facce o scalenoedri con più di otto lati. “I ricercatori precedenti, -dice ancora Bralower– non avevano visto queste strutture perché non ingrandivano abbastanza. “I microcristalli sono notevolmente simili ,- riportano Bralower e colleghi– al carbonato di calcio prodotto dai batteri dei nostri giorni, e quindi la maggior parte della micrite è probabilmente di origine biologica”. La vita che ha creato questo minerale noto come micrite,- suggeriscono i ricercatori-, era probabilmente parte di una “comunità microbica sopravvissuta” emersa all’indomani dell’impatto. Oltre a spazzare via così tanta vita sulla terraferma, l‘impatto ha decimato anche gli ecosistemi oceanici. La roccia vaporizzata ha portato ad un accumulo di acido solforico che è piovuto sugli oceani insieme a metalli tossici come piombo e mercurio. Più del 90% del fitoplancton marino,- hanno dimostrato i ricercatori- si è estinto. “Eppure, quella distruzione, -dice Julio Sepúlveda, biogeochimico dell’Università del Colorado-, ha anche aperto la strada ai nuovi arrivati. Boulder, che non è stato coinvolto nella ricerca, puntualizza: “Se elimini un gruppo importante da un ecosistema, hai una nicchia ecologica vuota”. Quei nuovi arrivati, altre alghe e batteri fotosintetici -dice ancora Bralower-, erano “pronti a conquistare il mondo”. Poiché proliferavano in fioriture oceaniche, avrebbero agito loro stessi come fonte di cibo, per animali più in alto nella catena alimentare, come krill e gamberetti, suggeriscono sempre Bralower e colleghi. Ed hanno lasciato la prova della loro esistenza sotto forma di micrite. Vale la pena, suggeriscono infine questi ricercatori, scavare più nel passato per cercare fioriture simili dopo altre estinzioni di massa. “Guardare, per esempio, -aggiunge infine Bralower- l’estinzione del Permiano 252 milioni di anni fa, quando un enorme cataclisma, ha ucciso più del 90% delle specie del pianeta, sarebbe un buon punto di partenza . Scommetto che guardando alla fine del Permiano, troverei queste strutture anche lì.”

Come sta cambiando l’Artico in rapido riscaldamento

Sono grandi i rischi che possono ingenerarsi per lo scioglimento del permafrost

L’estremo Nord si sta riscaldando più rapidamente rispetto alle regioni a latitudine inferiore, a causa di un processo noto come amplificazione artica. Ciò si verifica perché il ghiaccio marino di colore chiaro, che riflette il calore nello spazio, viene sostituito dall’acqua dell’oceano più scura, che intrappola il calore. Inoltre, le acque oceaniche relativamente calde non sono più schermate in inverno in modo altrettanto efficace dalle proprietà isolanti del ghiaccio marino spesso. I cambiamenti nel clima artico sono così profondi che l’estensione media del ghiaccio marino a settembre, quando raggiunge il suo minimo annuale, è diminuita del 31% dal primo decennio dell’era satellitare (1979-88).Landrum e Holland volevano determinare se questo declino dimostra che il clima artico è cambiato radicalmente. Volevano anche studiare i cambiamenti in altri due aspetti chiave che sono indicativi dello stato ghiacciato del clima artico: le temperature dell’aria in autunno e in inverno e la transizione stagionale delle precipitazioni dalla maggior parte della neve alla pioggia. Per rispondere a queste domande, si sono rivolti a più simulazioni da cinque dei principali modelli climatici del mondo che sono stati utilizzati per un progetto di ricerca internazionale noto come Coupled Model Intercomparison Project 5 o CMIP5. Il gran numero di simulazioni ha consentito loro di raccogliere, un quadro statisticamente significativo del clima artico, consentendo loro di differenziare la variabilità climatica naturale di anno in anno da una transizione a un nuovo clima artico. Gli scienziati hanno confrontato l’output del modello con le osservazioni, confermando che i modelli stavano catturando accuratamente il clima passato e quindi potevano simulare in modo affidabile il clima futuro. Landrum e Holland hanno applicato tecniche statistiche per determinare quando i cambiamenti climatici hanno superato i limiti della variabilità naturale. In altre parole, se l’estensione del ghiaccio marino è cambiata così tanto che la media, diciamo, negli anni ’90 era inferiore nel 97,7% di tutti i casi rispetto all’estensione del ghiaccio marino per qualsiasi anno negli anni ’50, allora gli anni ’90 sono stati definiti come un nuovo clima. Quando hanno applicato queste tecniche all’estensione del ghiaccio marino, hanno scoperto che l‘Artico è già entrato in un nuovo clima. Ciascuno dei cinque modelli mostrava un ritiro del ghiaccio marino così drammatico che un nuovo clima per il ghiaccio marino era emerso tra la fine del XX e l’inizio del XXI secolo. Guardando al futuro, hanno anche scoperto che l’Artico potrebbe iniziare a sperimentare condizioni in gran parte senza ghiaccio nei prossimi decenni. Molti modelli hanno indicato che l’Artico potrebbe diventare per lo più privo di ghiaccio per 3-10 mesi all’anno entro la fine del secolo, sulla base di uno scenario di elevate emissioni di gas serra. In termini di temperatura dell’aria, Landrum e Holland si sono concentrati sull’autunno e sull’inverno, fortemente influenzati dalla riduzione estiva del ghiaccio marino e dal successivo momento della ricrescita dei ghiacci. Perciò le temperature dell’aria sull’oceano entreranno in un nuovo clima durante la prima metà o la metà di questo secolo, con temperature dell’aria sul riscaldamento della terra sostanzialmente più tardi nel secolo. Il ciclo stagionale delle precipitazioni cambierà drasticamente entro la metà del secolo. Se le emissioni persistono a un livello elevato, la maggior parte delle regioni continentali sperimenterà un aumento nella stagione delle piogge di 20-60 giorni entro la metà del secolo e di 60-90 giorni entro la fine del secolo. In alcune regioni artiche, la pioggia può verificarsi in qualsiasi mese dell’anno entro la fine del secolo. “È probabile che l’Artico sperimenterà estremi di ghiaccio marino, temperatura e precipitazioni ,- ha detto Landrum-, che sono molto al di fuori di qualsiasi cosa che abbiamo sperimentato prima. Dobbiamo quindi cambiare la nostra definizione di cosa sia il clima artico”. Il ghiaccio dell‘Artico che si sta sciogliendo, porta con sé conseguenze molto più a largo spettro, di quelle che si potrebbero immaginare. Parlando di scioglimento dei ghiacciai, si pensa subito all’innalzamento del livello del mare e, conseguentemente, delle temperature, ma la minaccia non si esaurisce qui. Con il riscaldamento globale, si sta assistendo una progressiva e sempre più esponenziale diminuzione del volume dei ghiacciai presenti sul pianeta, tra cui quelli dell’Artico. Se negli anni ’80, infatti, il ghiaccio di questi costituiva il 20% della calotta polare, ad oggi si è ridotto a solo il 3%. Questo fatto , si traduce in un innalzamento dei livelli del mare, ma disegna una grandissima minaccia per il permafrost (il suolo “perennemente” ghiacciato).Sotto il permafrost, sono intrappolati oltre 1500 miliardi di tonnellate di gas serra, di cui la maggior parte costituite da metano, gas con una mole 25 volte più dannosa rispetto l’anidride carbonica. Se questa spaventosa quantità venisse rilasciata nell’atmosfera (di questo passo si prevede avverrà nel giro di pochi decenni), l’impatto sulle temperature medie del pianeta sarebbe irreversibile e di gravissima entità. Il metano è il prodotto dalla decomposizione batterica delle carcasse di animali morti e dei resti vegetali, che nel corso dei millenni si sono accumulati nel ghiaccio. Si trova dentro delle vere e proprie “bolle”, che esplodono in atmosfera man mano che risalgono in superficie dallo scioglimento del ghiaccio. Questo è il cosiddetto termocarsismo. E il fenomeno sta provocando un cambiamento anche del panorama naturale delle aree direttamente interessate, come si è visto in questi ultimi mesi. Le superfici si sono bucherellate, somigliando a quelle che si trovano nelle regioni carsiche. Nel momento in cui il ghiaccio che tratteneva il terreno si scioglie, il suolo subisce un collasso e si formano veri e propri buchi che si riempiono d’acqua, alimentando lo scioglimento e portando a frane e lo sradicamento di alberi. Inoltre, proprio in questi giorni il notizia coronavirus ha raggiunto tutto il mondo, portando grande allarme specialmente in Italia,ma per la nostra salute è molto più minaccioso lo scioglimento dei ghiacciai, rispetto a questo singolo virus, che ha assunto la stessa importanza che si potrebbe attribuire ad un’epidemia letale (cosa che non è).All’interno del permafrost è presente un numero significativo di microrganismi vitali, che nell’Artico risalgono fino a circa 3 milioni e mezzo di anni fa. Proprio per questo c’è grande preoccupazione nelle zone dell’estremo Nord, dove, per esempio, dai resti di un mammut è stato riattivato un  . Il timore è che si liberino virus che il nostro organismo non riconosce e potrebbe non essere attrezzato a combattere. Non tutti i batteri possono tornare in vita dopo essere stati congelati nel permafrost, ma quelli dell’antrace possono farlo perché formano spore, estremamente resistenti e possono sopravvivere congelate per più di un secolo. Ad oggi, particolari virus che sono stati rinvenuti, hanno dimostrato di infettare solo amebe monocellulari. Tuttavia, non è da escludere che un domani, altri virus, virulenti per gli esseri umani, potrebbero essere rianimati allo stesso modo, mettendo a grave rischio la nostra salute.

. Il timore è che si liberino virus che il nostro organismo non riconosce e potrebbe non essere attrezzato a combattere. Non tutti i batteri possono tornare in vita dopo essere stati congelati nel permafrost, ma quelli dell’antrace possono farlo perché formano spore, estremamente resistenti e possono sopravvivere congelate per più di un secolo. Ad oggi, particolari virus che sono stati rinvenuti, hanno dimostrato di infettare solo amebe monocellulari. Tuttavia, non è da escludere che un domani, altri virus, virulenti per gli esseri umani, potrebbero essere rianimati allo stesso modo, mettendo a grave rischio la nostra salute.

I pericoli annunciati dello scioglimento del permafrost e del cambiamento climatico dell’Artico

L’Artico in rapido riscaldamento sta passando da uno stato prevalentemente ghiacciato a un clima completamente diverso, secondo un nuovo studio completo delle sue condizioni climatiche. I modelli meteorologici alle latitudini superiori sono sempre variati di anno in anno, con più o meno ghiaccio marino, inverni più freddi o più caldi e stagioni di pioggia più o meno lunghe invece della neve. La nuova ricerca degli scienziati del National Center for Atmospheric Research (NCAR), rileva che l’Artico si è ora riscaldato in modo così significativo: la sua variabilità da un anno all’altro si sta spostando al di fuori dei limiti di qualsiasi fluttuazione del passato, segnalando la transizione verso un “nuovo regime climatico artico” Il tasso di cambiamento è notevole,- ha detto la scienziata dell’NCAR Laura Landrum,- ed è un periodo di cambiamenti così rapidi che le osservazioni dei modelli meteorologici passati non mostrano più cosa ci si può aspettare il prossimo anno. L’Artico sta già entrando in un clima completamente diverso rispetto a pochi decenni fa”. Landrum e la scienziata dell’NCAR Marika Holland, hanno scoperto che il ghiaccio marino artico si è sciolto in modo così significativo negli ultimi decenni e quindi, anche un anno insolitamente freddo non avrà più la quantità di ghiaccio marino estivo che esisteva fino alla metà del XX secolo. Le temperature dell’aria autunnale e invernale saranno abbastanza calde da entrare in un clima statisticamente distinto entro la metà di questo secolo, seguito da un cambiamento stagionale delle precipitazioni che si tradurrà in mesi aggiuntivi in cui cadrà la pioggia invece della neve. Sono state utilizzate centinaia di dettagliate simulazioni al computer e osservazioni delle condizioni climatiche dell’Artico. La grande quantità di dati ha permesso di definire statisticamente i confini climatici del “vecchio Artico” – o quanta variabilità può verificarsi naturalmente di anno in anno – e quindi di identificare quando il riscaldamento causato dall’uomo spingerà l’Artico oltre quei naturali limiti e in un nuovo clima. Le proiezioni future utilizzate per lo studio si basano su uno scenario di fascia alta per le future emissioni di gas a effetto serra, una traiettoria nota come RCP 8.5. Il documento rileva, tuttavia, che la riduzione delle emissioni ridurrebbe l’entità del cambiamento climatico nell’Artico. Il cambiamento climatico ha enormi conseguenze di vasta portata per gli ecosistemi, la gestione delle risorse idriche, la pianificazione delle inondazioni e le infrastrutture.

Importanti novità sull’entanglement quantistico

Il professore di fisica della Louisiana State University Mark M. Wilde e il suo collaboratore Xin Wang hanno risolto un problema che risale a 20 anni addietro, nella teoria dell’informazione quantistica: come va calcolato il costo dell’entanglement – un modo per misurare l’entanglement – di modo che sia efficacemente calcolabile, utile e ampiamente applicabile in diverse aree di ricerca quantistica. Wilde e Dr. Xin Wang di Baidu Research descrivono come consentire una gamma leggermente più ampia di operazioni fisiche, rispetto a ciò che è noto come LOCC (operazioni locali e comunicazione classica) – che avevano sbalordito scienziati per una matematica difficile per qualche tempo – rendendo possibile caratterizzare l’esatto costo di entanglement di un dato stato quantico. Il lavoro chiude un’indagine di lunga data sulla teoria dell’entanglement, nota come “costo di entanglement esatto PPT di uno stato quantico“. La scienza dell’informazione quantistica mira a comprendere e controllare le proprietà strane e talvolta spettrali degli stati quantistici (cioè, gli stati intrecciati) che consentono attività di elaborazione delle informazioni impossibili nel mondo non quantico, come il teletrasporto, il calcolo quantistico e la comunicazione assolutamente sicura. L’unità più elementare di entanglement è conosciuta come stato di Bell. Va pensata come la più piccola molecola possibile composta da due atomi intrecciati (qubit, in realtà) il cui entanglement è assoluto .Ciò implica, se potessi sbirciare uno di loro, sapresti oltre ogni dubbio che l’altro sarebbe il suo gemello, con le stesse caratteristiche. Come due persone che lanciano una moneta; se una persona ottiene la coda, il che è ragionevolmente una probabilità del 50/50, l’altra sarebbe garantita per ottenere la coda (o entrambi ottengono la testa, stessa cosa), una conseguenza dell’entusiasmo assoluto o di uno stato di Bell. Inoltre, nessun altro nell’universo può conoscere l’esatto risultato del lancio della moneta, e questa è la ragione principale per cui una comunicazione protetta basata sull’entanglement quantistico è possibile e desiderabile. “L’entanglement quantistico, -ha spiegato Wilde-è una sorta di super correlazione condivisa da due parti distanti. Se il mondo fosse descritto solo dalla fisica classica, non sarebbe possibile avere le forti correlazioni disponibili con l’entanglement quantistico. Tuttavia, il nostro mondo è fondamentalmente meccanico quantistico e l’entanglement ne è una caratteristica essenziale.” Quando l’entanglement quantistico fu scoperto per la prima volta negli anni ’30, si pensava che fosse un fastidio: era difficile da capire e non era chiaro quali sarebbero stati i suoi benefici. Con l’ascesa della scienza dell’informazione quantistica negli anni ’90, è stata intesa in senso teorico come la chiave di notevoli tecnologie quantistiche. Esempi recenti di tali tecnologie includono l’esperimento di teletrasporto cinese da terra a satellite nel 2017 e il successo di supremazia quantistica computazionale di Google, l’anno scorso. Alla LSU, fisici quantistici come Omar Magaña-Loaiza e Thomas Corbitt eseguono abitualmente esperimenti che potrebbero beneficiare della nuova e più precisa misura di Wilde e Wang. Nei rispettivi laboratori, Magaña-Loaiza, hanno recentemente generato stati intrecciati attraverso misurazioni condizionali, che costituiscono un passo importante nello sviluppo di sistemi simili a laser intrappolati, mentre Corbitt ha condotto uno studio sull’ entanglement optomeccanico, che ha il potenziale di essere una fonte affidabile di entanglement multifotone a lunghezze d’onda corte. La nuova misura di entanglement di Wilde e Wang, chiamata? entanglement o negatività max-logaritmica, può essere utilizzata per valutare e quantificare l’ entanglement prodotto in una vasta gamma di esperimenti quantistici-fisici. Le unità di entanglement di base o gli stati di Bell sono anche noti come e-bit. L’entanglement può essere visto in due modi diversi: o quanti bit elettronici ci vorranno per preparare uno stato quantico, o quanti bit elettronici uno si potrebbero estrarre o “distillare” da uno stato complesso aggrovigliato. Il primo è noto come costo di entanglement ed è il problema considerato da Wilde e Wang. “Gli e-bit sono una risorsa preziosa, -ha detto Wilde– e quindi da usarne il minor numero possibile. In fisica, spesso vuoi guardare sia al processo in avanti che al processo all’indietro. È reversibile? E se lo è, perdo qualcosa lungo la strada? E la risposta è sì.” Wilde ammette che il problema che lui e Wang hanno risolto è in qualche modo esoterico: un trucco matematico. Tuttavia, questo consentirà agli scienziati dell’informazione quantistica di calcolare in modo efficiente i costi di entanglement, dati determinati vincoli.

“Non tutte le misure di entanglement, -ha aggiunto Wilde– sono calcolabili in modo efficiente e hanno un significato come costo di entanglement. Questa è una distinzione chiave tra tutto il lavoro precedente e il nostro”. Mentre la mancanza di questo tipo di misura è stata un tallone di Achille nella scienza dell’informazione quantistica per oltre 20 anni, il successo inaspettato è stato dovuto – ironia della sorte – a Wilde divenuto max-negativamente “impigliato” durante una partita di basket nel 2018 che lo ha portato, alla fine con Wang a riuscire a risolvere il problema. “Mi sono rotto il tallone d’Achille, -ricorda Wilde– mentre cercavo il punto vincente del gioco, poi ho subito un intervento chirurgico per ripararlo e non sono riuscito ad alzarmi dal letto per un mese e mezzo”. “Così, ho scritto un documento di ricerca sul costo di entanglement – prosegue Wilde-e quando Xin Wang lo ha saputo, mi ha chiesto se fossi stato interessato a sviluppare ulteriormente questo problema. Abbiamo quindi iniziato a lavorare insieme, avanti e indietro, e quello è diventato il documento ora pubblicato. In seguito, siamo diventati buoni amici e collaboratori -ma è davvero sorprendente le sorprese che possono verificarsi nella vita “.

I funghi possono aiutare nell’invecchiamento cerebrale

Funghi commestibili

Uno studio di sei anni, condotto dal professore Lei Feng dell’Università Nazionale di Singapore, ha rilevato che gli anziani che mangiavano più di 300 grammi di funghi cucinati alla settimana avevano la metà delle probabilità di avere un lieve deficit cognitivo. Dr. Irwin Cheah (a destra) è un altro membro del team di ricerca dell’università di Singapore. Una squadra del Dipartimento di Medicina Psicologica e Dipartimento di Biochimica della Yong Loo Lin School of Medicine dell’Università Nazionale di Singapore (NUS) ha scoperto che gli anziani che consumano più di due porzioni standard di funghi settimanali possono avere il 50% di probabilità ridotte di avere, lieve deterioramento cognitivo (MCI). La porzione era definita come tre quarti di una tazza di funghi cotti con un peso medio di circa 150 grammi. Due porzioni equivalgono a circa mezzo piatto. Mentre le dimensioni delle porzioni fungono da linea guida, è stato dimostrato che anche una piccola porzione di funghi alla settimana si rivela utile per ridurre le probabilità di MCI. “La correlazione è sorprendente e incoraggiante: sembra che un singolo ingrediente, – ha detto il professor Lei Feng, del Dipartimento di Medicina Psicologica del NUS- comunemente disponibile possa avere un effetto drammatico sul declino cognitivo” . Lo studio condotto dal 2011 al 2017, con il sostegno del Life Sciences Institute e del Mind Science Center del NUS, nonché del National Medical Research Council del Ministero della Salute di Singapore ha raccolto dati di oltre 600 anziani cinesi di età superiore ai 60 anni residenti a Singapore.

Determinazione di MCI negli anziani

L’MCI è generalmente vista come lo stadio tra il declino cognitivo dell’invecchiamento normale e il più grave declino della demenza. Gli anziani affetti da MCI spesso mostrano qualche forma di perdita di memoria o dimenticanza e possono anche mostrare deficit su altre funzioni cognitive come la lingua, l’attenzione e le abilità visuospaziali. I cambiamenti possono essere impercettibili, poiché non presentano deficit cognitivi invalidanti che influenzano le attività della vita quotidiana, caratteristiche dell’Alzheimer e di altre forme di demenza senile. “Le persone con MCI – ha spiegato il prof. Feng-, sono ancora in grado di svolgere le loro normali attività quotidiane. Questo studio ha determinato se questi anziani hanno prestazioni più scarse nei test standard neuropsicologici rispetto ad altre persone della stessa età e formazione”. I test neuropsicologici sono specificamente progettati e possono misurare vari aspetti delle capacità cognitive di una persona, infatti alcuni dei test che abbiamo utilizzato in questo studio sono adottati dalla batteria di test IQ comunemente usata, la Wechsler Adult Intelligence Scale (WAIS).” In quanto tali, sono state condotte interviste e test approfonditi con gli anziani per determinare una diagnosi accurata. “L’intervista, -ha dichiarato il prof Feng -prende in considerazione informazioni demografiche, anamnesi, fattori psicologici e abitudini alimentari: un infermiere misurerà la pressione sanguigna, il peso, l’altezza, l’impugnatura e la velocità del cammino e eseguirà anche un semplice test di screening su cognizione, depressione, ansia “. Dopo questo, è stata eseguita una valutazione neuropsicologica standard di due ore, insieme a un punteggio di demenza. I risultati complessivi di questi test sono stati discussi in profondità con esperti psichiatri coinvolti nello studio per ottenere un consenso diagnostico.

Funghi e deterioramento cognitivo

Sei funghi comunemente consumati a Singapore sono stati citati nello studio. Erano funghi d’oro, ostriche, shiitake e bianchi, oltre a funghi secchi e in scatola. E’ probabile che anche altri funghi non citati abbiano effetti benefici. La ragione della ridotta prevalenza di MCI nei mangiatori di funghi potrebbe essere dovuta a uno specifico composto presente in quasi tutte le varietà. “Siamo interessati a un composto chiamato ergothioneine (ET)”,- ha affermato il dott. Irwin Cheah, Senior Research Fellow del Dipartimento di Biochimica del NUS_- l’ET è un antiossidante e anti-infiammatorio unico che gli esseri umani non sono in grado di sintetizzare da soli, ma può essere ottenuto da fonti alimentari, tra le quali i principali sono i funghi”. Uno studio precedente condotto dal gruppo, sugli anziani di Singapore, ha rivelato che i livelli plasmatici di ET nei partecipanti con MCI erano significativamente inferiori rispetto agli individui sani di età corrispondente. Il lavoro ha portato alla convinzione che una carenza di ET potrebbe essere un fattore di rischio per la neurodegenerazione, e l’aumento dell’apporto di ET attraverso il consumo di funghi potrebbe promuovere la salute cognitiva. Altri composti contenuti nei funghi possono anche essere vantaggiosi per ridurre il rischio di declino cognitivo. Alcuni hericenones, erinacines, scabronine e dictyophorines possono promuovere la sintesi dei fattori di crescita del nervo. I composti bioattivi nei funghi possono anche proteggere il cervello dalla neurodegenerazione inibendo la produzione di beta amiloide, tau fosforilata e acetilcolinesterasi.

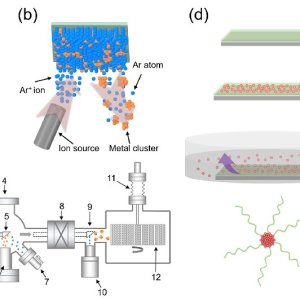

Rimozione sostanze tossiche nell’acqua con metodo ecologico

I ricercatori dell’Università di Swansea hanno sviluppato un nuovo metodo ecologico per la rimozione di sostanze chimiche tossiche dall’acqua. Una macchina di nuova invenzione, chiamata Matrix Assembly Cluster Source (MACS), è stata utilizzata per progettare un metodo innovativo di trattamento delle acque utilizzando un approccio privo di solventi. La ricerca, condotta all’Institute for Innovative Materials, Processing and Numerical Technologies (IMPACT) all’interno del College of Engineering della Swansea University, è guidata dal professor Richard Palmer. “Le molecole organiche dannose,- spiega Palmer- vengono distrutte da un potente agente ossidante, l’ozono, che viene potenziato da un catalizzatore. Di solito tali catalizzatori sono fabbricati con metodi chimici usando solventi, il che crea un altro problema: come gestire gli effluenti dal processo di fabbricazione? L’innovazione di Swansea è una macchina appena inventata che produce il catalizzatore con metodi fisici, senza solventi e quindi senza effluenti. La nuova tecnica è un cambiamento radicale nell’approccio al trattamento delle acque e ad altri processi catalitici “.: “Il nostro nuovo approccio alla realizzazione di catalizzatori per i trattamenti delle acque- ha continuato Palmer- utilizza un processo fisico basato sul vuoto e privo di solventi. Le particelle di catalizzatore sono ammassi di atomi d’argento, realizzati con la macchina MACS appena inventata. Risolve il problema di vecchia data del basso tasso di produzione dei cluster – il che significa che, per la prima volta, è ora possibile produrre abbastanza cluster per lo studio a livello di provetta, con il potenziale per poi scalare ulteriormente al livello di produzione in piccoli lotti e oltre. ” I grappoli sono circa 10.000 volte più piccoli della larghezza di un capello umano e sono stati di notevole interesse per i ricercatori a causa delle loro proprietà uniche. Tuttavia, a causa del tasso inadeguato di produzione di cluster, la ricerca in questo settore è stata limitata. Il nuovo metodo MACS ha cambiato questo aspetto: aumenta l’intensità del fascio di cluster per produrre abbastanza grammi di polvere di cluster per test pratici. L’aggiunta di ozono alla polvere, quindi, distrugge i prodotti chimici inquinanti dall’acqua, in questo caso il nitrofenolo. “L’approccio MACS alla progettazione su scala nanometrica di materiali funzionali -riassume Palmer sul potenziale futuro di questa tecnologia rivoluzionaria, – apre orizzonti completamente nuovi in una vasta gamma di discipline – dalla fisica e chimica alla biologia e ingegneria. Pertanto, ha il potere di consentire progressi radicali nella tecnologia avanzata: catalizzatori, biosensori, materiali per la generazione e lo stoccaggio di energia rinnovabile. Sembra molto appropriato che la prima dimostrazione pratica del processo di produzione ecocompatibile di Swansea riguardi qualcosa di cui tutti siamo preoccupati: l’acqua pulita! “

Lo schema e la mappa

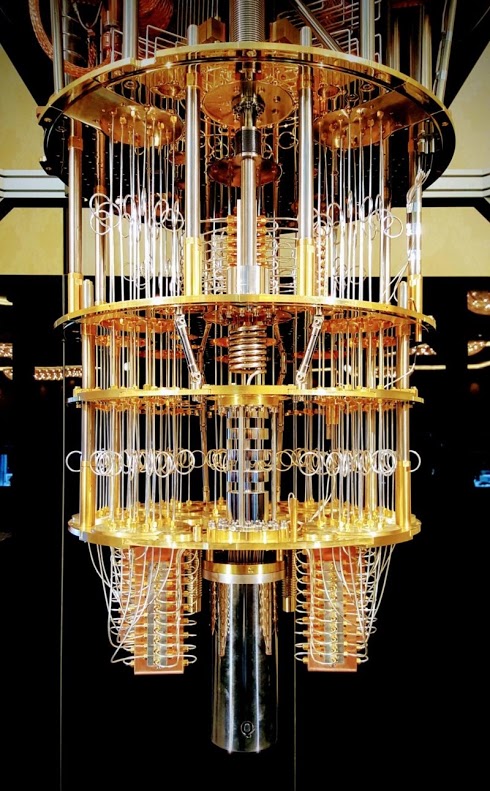

NUOVE OPZIONI PER LA CODIFICA DEI COMPUTER QUANTISTICI

Il teorico e sviluppatore dell’algoritmo quantistico PNNL Nathan Wiebe sta applicando idee dalla scienza dei dati e dagli hack di gioco al calcolo quantistico. Tutti coloro che lavorano su computer quantistici sanno che i dispositivi sono soggetti a errori. L’unità base della programmazione quantistica – la porta quantistica – fallisce circa una volta ogni cento operazioni. E quel tasso di errore è troppo alto. Nathan Wiebe di PNNL sta anticipando la scrittura di codice che è sicuro che verrà eseguito su computer quantistici quando saranno pronti. Professore di fisica all’Università di Washington, Wiebe sta formando la prossima generazione di teorici e programmatori di calcolo quantistico. Lamenta che “c’è un abisso così grande tra dove siamo adesso e dove dobbiamo essere, ma altrettanto rapidamente, elimina i dubbi e spiega che “siamo già nel punto in cui stiamo facendo cose che sono davvero interessanti”. È questa mentalità all’avanguardia che lo ha collocato come leader globale nello sviluppo di algoritmi quantistici . La codifica per computer quantistici richiede sbalzi di immaginazione che possono essere scoraggianti su un livello, ma Wiebe sottolinea che qualsiasi appassionato di Minecraft di 15 anni non avrebbe problemi a comprendere le basi di come funziona. Il popolare videogioco building block ha generato una comunità di programmatori entusiasti . L’universo di Minecraft ha le sue regole interne e alcune di esse non hanno del tutto senso – proprio come alcune delle regole dell’universo quantico non sembrano chiare, nemmeno ai fisici. Nonostante non capiscano perché le regole di Minecraft funzionano nel modo in cui funzionano, i giocatori imparano invece come funziona la fisica di Minecraft e come sfruttare tale conoscenza per svolgere compiti che i creatori di giochi potrebbero non aver inteso. I programmatori di computer quantistici hanno una sfida simile. Di fronte alle strane regole della meccanica quantistica, cercano di trovare modi creativi per “hackerarli” e costruire computer che, in alcuni casi, possono risolvere problemi trilioni di volte più veloci dei normali computer utilizzando effetti quantistici come l’interferenza e l’ entanglement che ordinario mancanza di computer. “Su un computer quantistico, – secondo le informazioni di Wiebe- quando provi a misurare i bit quantistici, ritornano ai bit ordinari. Con un computer quantistico devi essere più sottile di quanto non faccia con i computer ordinari. Devi convincere le informazioni sul sistema senza danneggiare le informazioni che sono state codificate lì. “Abbiamo trovato strane regole della meccanica quantistica, -ha dettagliato- e solo ora ci stiamo chiedendo come possiamo sfruttare queste regole per permetterci di calcolare“. Lo studio dell’efficienza dei motori termici ha rivelato la seconda legge della termodinamica, come lo studio dell’informatica quantistica potrebbe rivelare una comprensione più profonda dei limiti che la fisica pone sulla nostra capacità di calcolo, nonché delle nuove opportunità che offre collaborare tra i campi. “L’informatica quantistica non è semplicemente fisica, -ha spiegato Wiebe– esiste nell’intersezione tra molti campi, tra cui fisica, informatica, matematica, scienza dei materiali e, sempre più, scienza dei dati.Come Watt e Carnot, -dice ancora Wiebe- non abbiamo necessariamente bisogno di catturare tutta la minutia che sta accadendo all’interno del sistema. “Una delle prime utili tecnologie quantistiche è quella dei sensori quantistici, dispositivi che usano segnali quantici per misurare parametri come la temperatura e i campi magnetici. Wiebe ha lavorato con un team internazionale di colleghi per applicare le tecniche di apprendimento automatico a un problema delicato nel rilevamento quantico. I biologi vogliono usare questi sensori per misurare ciò che accade all’interno delle singole cellule. I sensori sono fatti di diamanti con alcuni difetti che possono essere utilizzati per inviare segnali quantici. Il problema è che, a temperatura ambiente, i segnali del sensore quantistico contengono troppi errori per essere pratici. Gli esperimenti sono positivi, a meno che il tutto non fosse raffreddato a temperature di elio liquido (-452,2 ° F), che ovviamente non è opportuna per le cellule viventi. Wiebe e colleghi hanno risolto il problema eseguendo gli esperimenti a temperatura ambiente e quindi applicando un algoritmo che utilizzava tecniche di analisi dei dati e apprendimento automatico per correggere il segnale soggetto a errori e rumoroso. “Abbiamo avuto, -ha poi spiegato – la stessa sensibilità dell’esperimento criogenico molto freddo senza costi aggiuntivi, affermando che applicare gli stessi principi potrebbe essere proprio la cosa necessaria per correggere porte quantistiche rumorose e soggette a errori. Wiebe, è fermamente convinto che rendere pratica l’informatica quantistica richiederà gli sforzi interdisciplinari combinati dei ricercatori in molti campi che imparano a parlare reciprocamente le lingue.” Se siamo in grado, -ha infine concluso-, di costruire un computer quantistico, allora abbiamo la capacità di risolvere problemi attualmente irrisolvibili in chimica e scienza dei materiali e fisica. La sfida impone entrambi limiti e offre nuove opportunità. Il calcolo quantistico ci obbliga a comprendere meglio cosa significa calcolare. “